現在、AI には多くの種類が存在します。これには、画像やテキスト、分析結果を生み出す生成 AI(GenAI)やコンピュータビジョン、自然言語処理(NLP)など、さまざまな種類のAIが含まれます。どのような種類であれ、企業は AI を自社の成果や戦略に合わせて活用する必要があります。エンタープライズ AI とは、レジリエンス、Day 2 運用、AI に関するセキュリティを重視した、ビジネス成果に焦点を当てたあらゆるタイプの AI のことです。

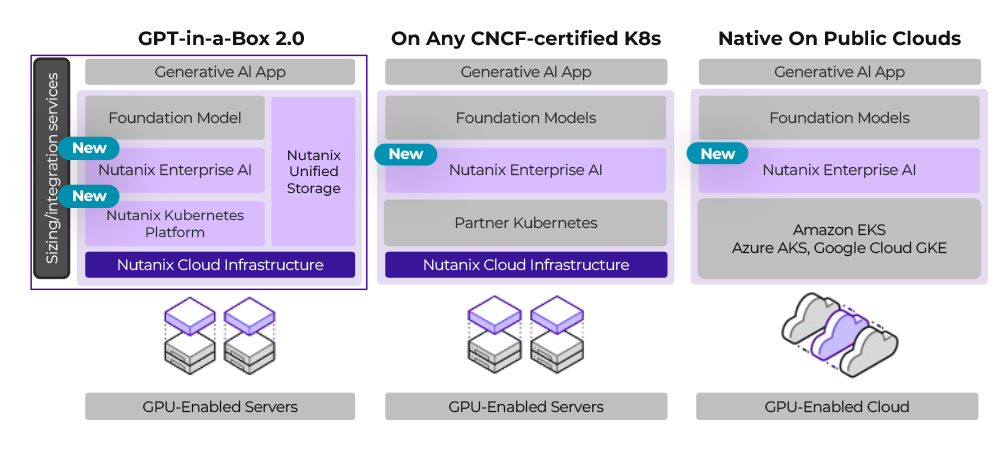

Nutanix GPT-in-a-Box はエンタープライズ AI に特化したソリューションです。サービス主導型の GPT-in-a-Box は、新たな製品や機能の追加により進化し、オンプレミスやパブリッククラウドにおいてターンキーインフラと、自在に組み合わせできるソリューションを提供しており、エンタープライズ AI を実現するのための最適な解決策となっています。

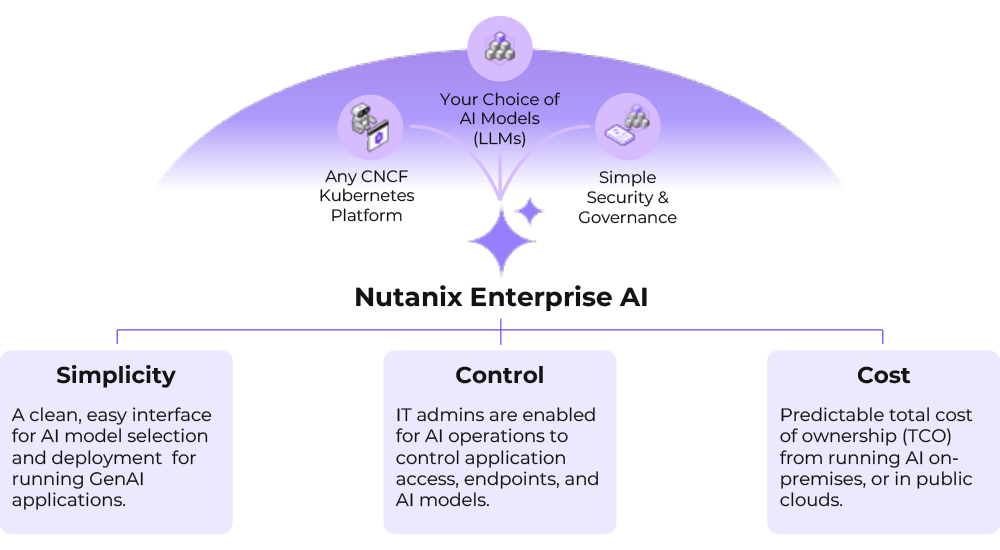

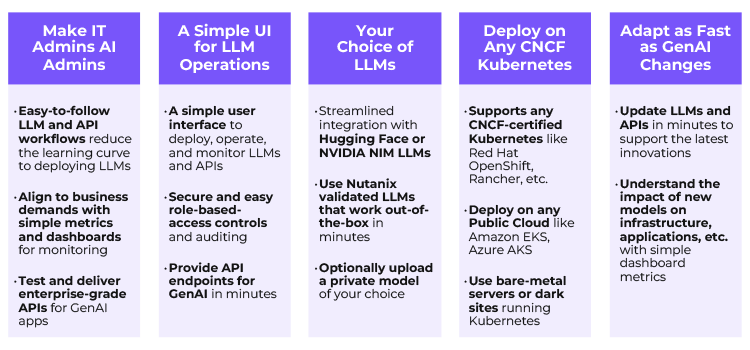

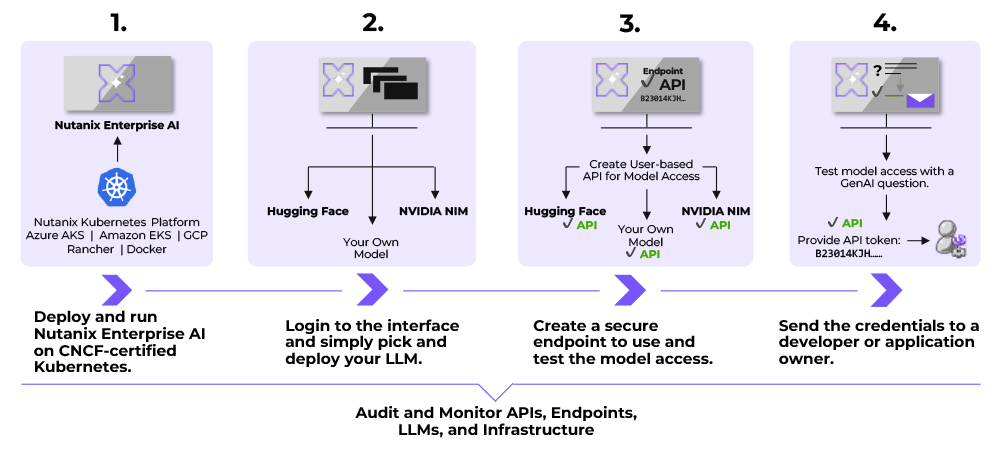

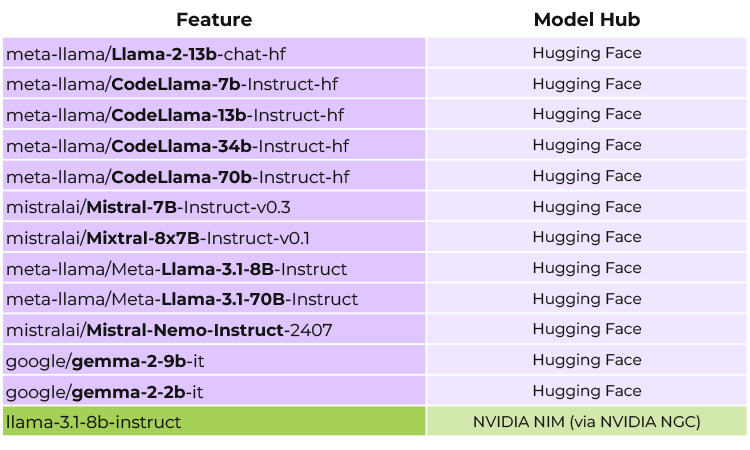

GPT-in-a-Box 2.0 の主な機能が Nutanix Enterprise AI 製品です。Nutanix Enterprise AI(NAI)は、エンタープライズ AI アプリケーションのための生成 AI モデル(LLM:大規模言語モデル)やセキュアな API のデプロイメント、運用、監視を簡素化します。Nutanix Enterprise AI は、GPT-in-a-Box を導入するお客さまが、エンタープライズ AI の具体的な効果を確認するうえで最初に使用するコンポーネントです。その使いやすさにより、新しい人材を採用する必要が大幅に減少、または完全に不要となり、既存の IT リソースを AI リソースに簡単に拡張できるようになります。