Nutanix Enterprise AI のご紹介:LLM のデプロイメントとエンドポイントのセキュリティをシンプルに

執筆者:AI 部門プロダクトマーケティングマネージャー Mike Barmonde

生成 AI はあらゆる場面で活用され、その価値は明白です。生成 AI は、生産性、顧客体験の向上、セキュリティの強化を通じて、ビジネスを変革しています。生成 AI を導入しない企業は、イノベーションが重視される市場で競争力を失うリスクを抱えています。しかし、生成 AI 戦略を構築するには、生成 AI のデプロイメント、運用、監視に対応できるインフラや人員の体制を整える必要があり、これが大きな課題となっています。

Nutanix は、引き続きこのようなニーズに応える「ソリューション」を提供しています。

Nutanix Enterprise AI の発表

Nutanix はこのたび、Nutanix Enterprise AI(NAI)の一般提供を開始しました。

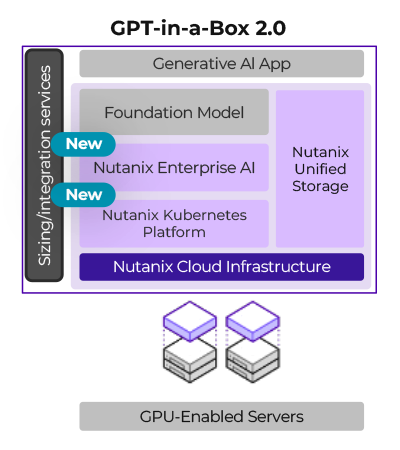

.NEXT 2024 のイベントで発表された GPT-in-a-Box 2.0 において明らかにされたように、 Nutanix Enterprise AI は、主要な LLM(大規模言語モデル)プロバイダから選択した LLM を容易にデプロイできる環境を提供します。また、生成 AI アプリケーションを接続するための安全な API を容易に作成・管理できる機能も備えています。

Nutanix Enterprise AI は、Nutanix Kubernetes Platform を備えた Nutanix GPT-in-a-Box 2.0 ソリューションの一部です。

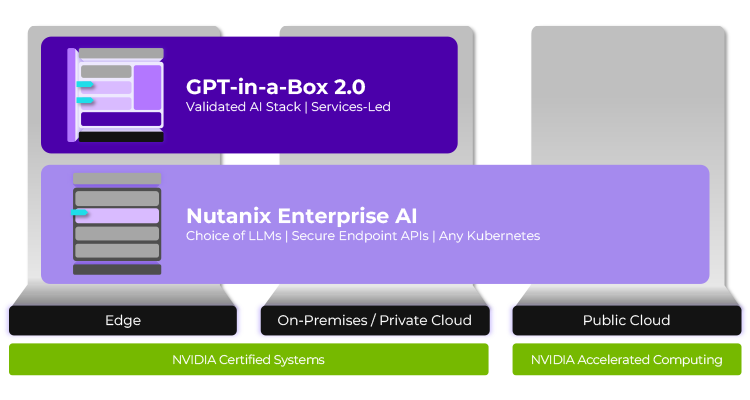

GPT-in-a-Box 2.0 ソリューションは、エッジまたはオンプレミスのプライベートクラウドに、耐障害性と安全性を備えたターンキーエンタープライズ AI スタックを提供します。Nutanix Enterprise AI は、GPT-in-a-Box の LLM の選択や、パブリッククラウドを含む Kubernetes 環境を実行する場所であればどこでも、Day-2 の運用を強化します。

Nutanix GPT-in-a-Box 2.0 は、エッジまたはオンプレミス/プライベートクラウドのエンタープライズ AI 向けです。Nutanix Enterprise AI は、パブリッククラウドで管理された Kubernetes でも実行可能で、NVIDIA 認定システムや NVIDIA アクセラレーテッドコンピューティングでの実行が認定されています。

主なメリット:

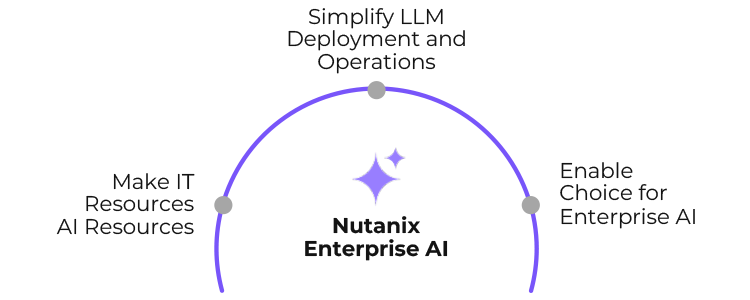

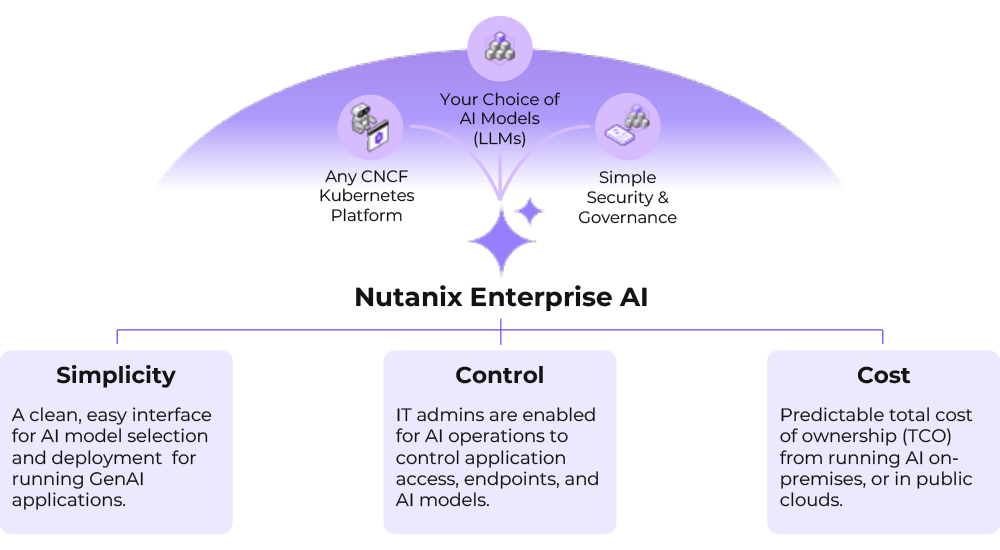

- IT リソースを AI リソースに変換:シンプルなワークフローとテスト機能を使用して、生成 AI アプリケーションのサポートを習得中の IT 担当者でも、すぐに仕事を始められます。

- LLM のデプロイメントと運用の簡素化:シンプルなユーザーインターフェースにより、LLM のデプロイメント、運用、監視が容易になり、ポイントアンドクリックでエンドポイントの保護、ロールベースのアクセス制御が可能になります。

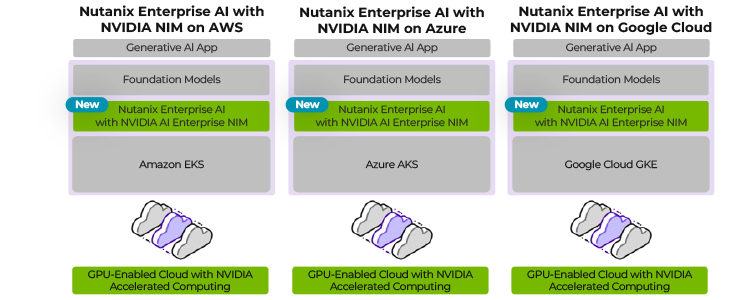

- NVIDIA AI 向けに最適化、検証済み:Nutanix Enterprise AI は、AWS、Azure、Google Cloud 上の NVIDIA アクセラレーションインスタンス上で動作し、NVIDIA AI Enterprise ソフトウェアでも認定されています。これには、一般的な基盤モデル向けの NVIDIA NIM 推論マイクロサービスが含まれます。標準的な生成 AI のユースケースのリファレンスワークフローである NVIDIA AI ブループリントは、GPT-in-a-Box でも使用可能で、サポートされるユースケースの可能性が広がります。

- Enterprise AI の充実した選択肢: Nutanix Enterprise AI は、Nutanix Kubernetes Platform を含む CNCF 認定の Kubernetes プラットフォーム上にデプロイできます。製品内では、統合により、リストされた LLM を NVIDIA NIM™ と連携することや、Hugging Face の使用、独自のカスタム LLM の提供ができます。

Nutanix Enterprise AI は、AI のための IT リソースを活用し、導入を簡素化し、AI の選択肢を可能にします。

Nutanix Enterprise AI のメリットは上記以外にもあります。

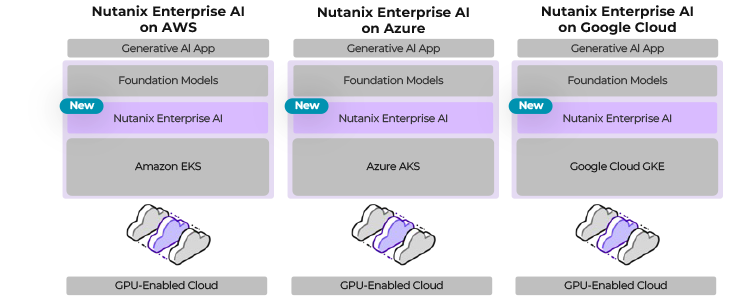

Nutanix Enterprise AI はパブリッククラウドを活用

Nutanix Enterprise AI は、パブリッククラウドを、組織が選択した安全な場所でモデルとデータを活用するための主要なランディングポイントとして採用しています。Nutanix Enterprise AI は、AWS、Microsoft Azure、Google Cloud で利用可能な NVIDIA アクセラレーテッドコンピューティングと完全に互換性があります。Nutanix Enterprise AI は、Kubernetes が動作する任意のパブリッククラウド上でも実行できます。

さらに、Nutanix Enterprise AI は Google Cloud でも利用可能になりました。Nutanix Enterprise AI は、初期段階では GKE(Google Kubernetes Engine)上で動作し、Nutanix プラットフォームに新たな機能を提供します。これにより、生成 AI を独自の方法であらゆる環境で活用できる新たな可能性が広がります。

多くの企業は、生成 AI アクティビティの開発やテストプラットフォームとしてパブリッククラウドを利用しています。Nutanix Enterprise AI は、AI モデルの展開や開発プロセスを簡素化し、パブリッククラウド VPC 上でのモデルのテストや生成 AI アプリの実行を迅速かつ効率的に行えるようにします。

Nutanix Enterprise AI は、Google Kubernetes Engine(GKE)、Amazon Elastic Kubernetes Service(EKS)、Azure Kubernetes Service(AKS)などのクラウド管理型 Kubernetes サービスにデプロイでき、パブリッククラウドでの生成 AI 戦略を簡素化できます。いずれも NVIDIA アクセラレーテッドコンピューティングでの実行をサポートしています。

パブリッククラウドサービスは、エッジ、オンプレミス、エアギャップなどのパブリッククラウドの外部での生成 AI ワークロードには対応していません。このようなユースケースでは、他のソリューションを探す必要があります。しかし、Nutanix Enterprise AI を使用することで、ハイブリッド・マルチクラウド環境全体で統一された運用が可能となり、企業の AI 戦略の実行可能性が向上します。

NVIDIA NIM の重要性

Nutanix Enterprise AI のリリースにおけるセキュアなエンドポイントのデプロイメントに、NVIDIA NIM マイクロサービスが重要な役割を担っています。では、なぜ NVIDIA NIM が Nutanix Enterprise AI にとって重要なのでしょうか?

NVIDIA NIM マイクロサービスは、Nutanix Enterprise AI を使用して、生成 AI アプリの開発とデプロイをシンプルで容易にします。

NVIDIA NIM は NVIDIA AI Enterprise の一部であり、クラウド、データセンター、ワークステーション全体で、事前トレーニング済みおよびカスタマイズされた AI モデルに推論マイクロサービスを提供しています。これをNutanix Enterprise AI のシンプルなインターフェースとセキュアなエンドポイントと組み合わせることで、エッジからパブリッククラウドまで、どこでもデプロイメント可能な完全で高速な生成 AI 推論ソリューションが実現します。

NVIDIA NIM マイクロサービスの利用を選択することで、AI アプリケーションや開発フレームワーク、ワークフローに対して GPU の AI モデル推論の性能の最適化を含む、安全な統合が容易になります。NIM は、オンプレミスとクラウドのあらゆる場所で動作し、Nutanix GPT-in-a-Boxや AWS、Google、Azure 上で Nutanix Enterprise AI とともにデプロイできます。NIM は、ハイブリッドインフラ間でのワークフローの移植性を可能にするだけでなく、超効率的な Nutanix ハイパーコンバージドインフラで低レイテンシと高スループットのために継続的に最適化されたモデルランタイムにより、運用コストを削減します。

Nutanix Enterprise AI の仕組み

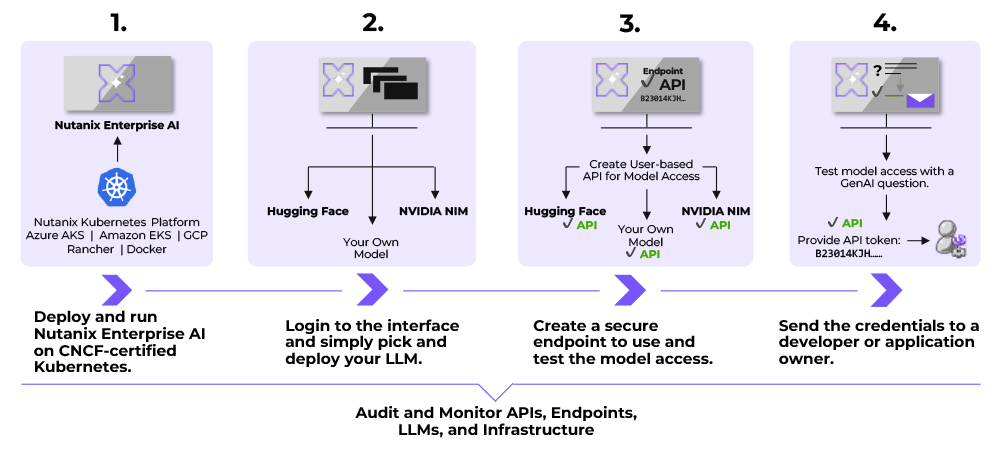

Nutanix Enterprise AI の利用は非常に簡単で、次の 4 つの簡単なステップで行えます。

Nutanix Enterprise AI は、AI モデル(LLM)のデプロイ、管理、監視と、エンドポイントの保護を 4 つの容易なステップで行えます。

1. Kubernetes を使用する環境を選択し、Nutanix Enterprise AI をデプロイします。

Nutanix Kubernetes Platform は、Nutanix Enterprise AI とすぐに統合できます。また、Google Cloud GKE、AWS EKS、Microsoft Azure AKS などの他の Kubernetes 環境を使用して手動でのデプロイメントも可能です。Kubernetes は、デプロイメントに現在必要な GPU を活用します。

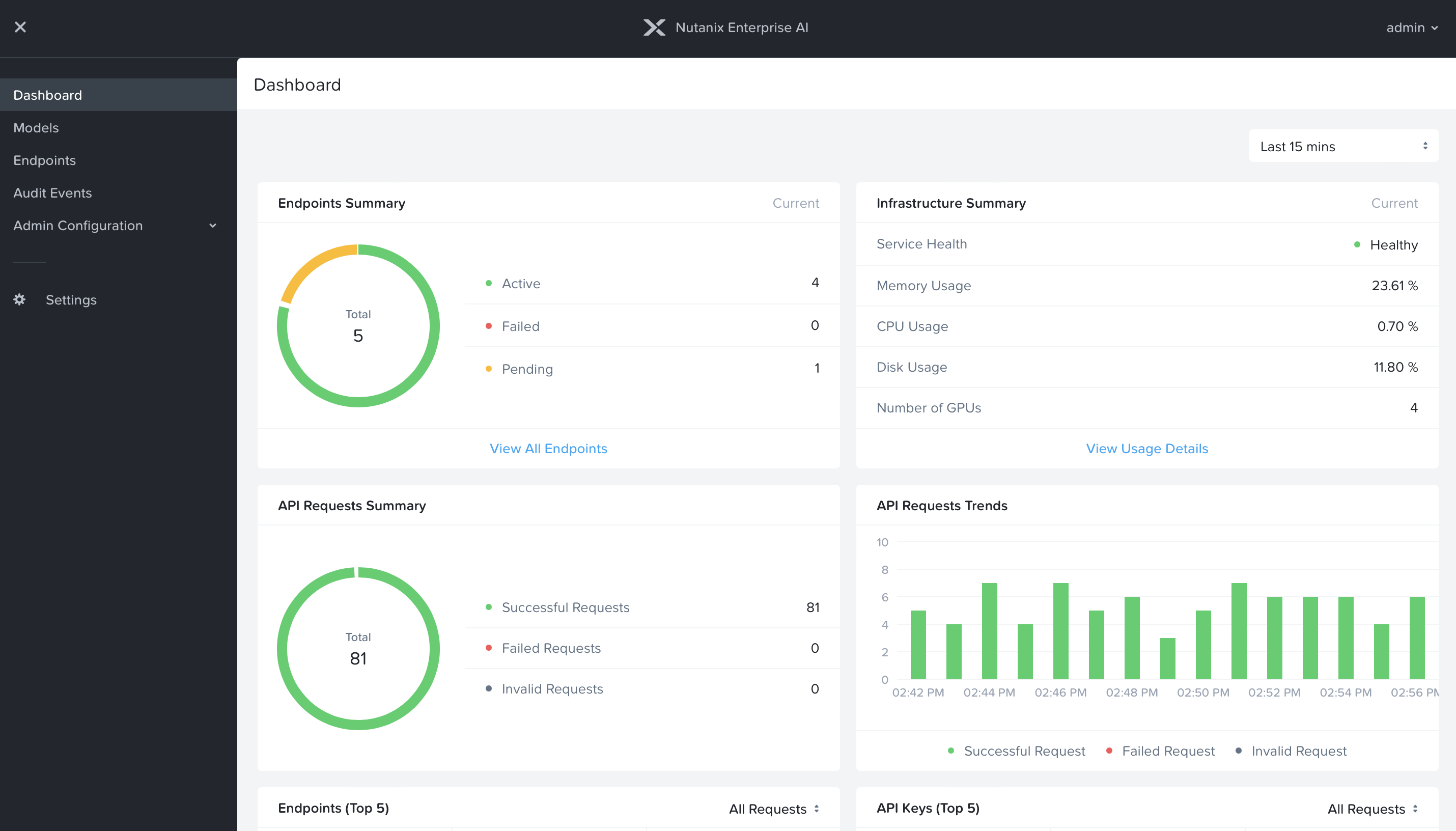

注意:Kubernetes クラスタのヘルスと GPU 使用率などの重要な統計は、管理者として Nutanix Enterprise AI ダッシュボードの「インフラサマリー」内で監視できます。Nutanix Enterprise AI は、安全な LLMOps のために「ダークサイト」やエアギャップ環境でも実行でき、接続なしでの運用を求められる場合にも対応します。

Nutanix Enterprise AI は、Kubernetes インフラ、GPU 使用率、上位の生成 AI エンドポイントなどの重要な項目の監視および監査機能を管理者に提供します。

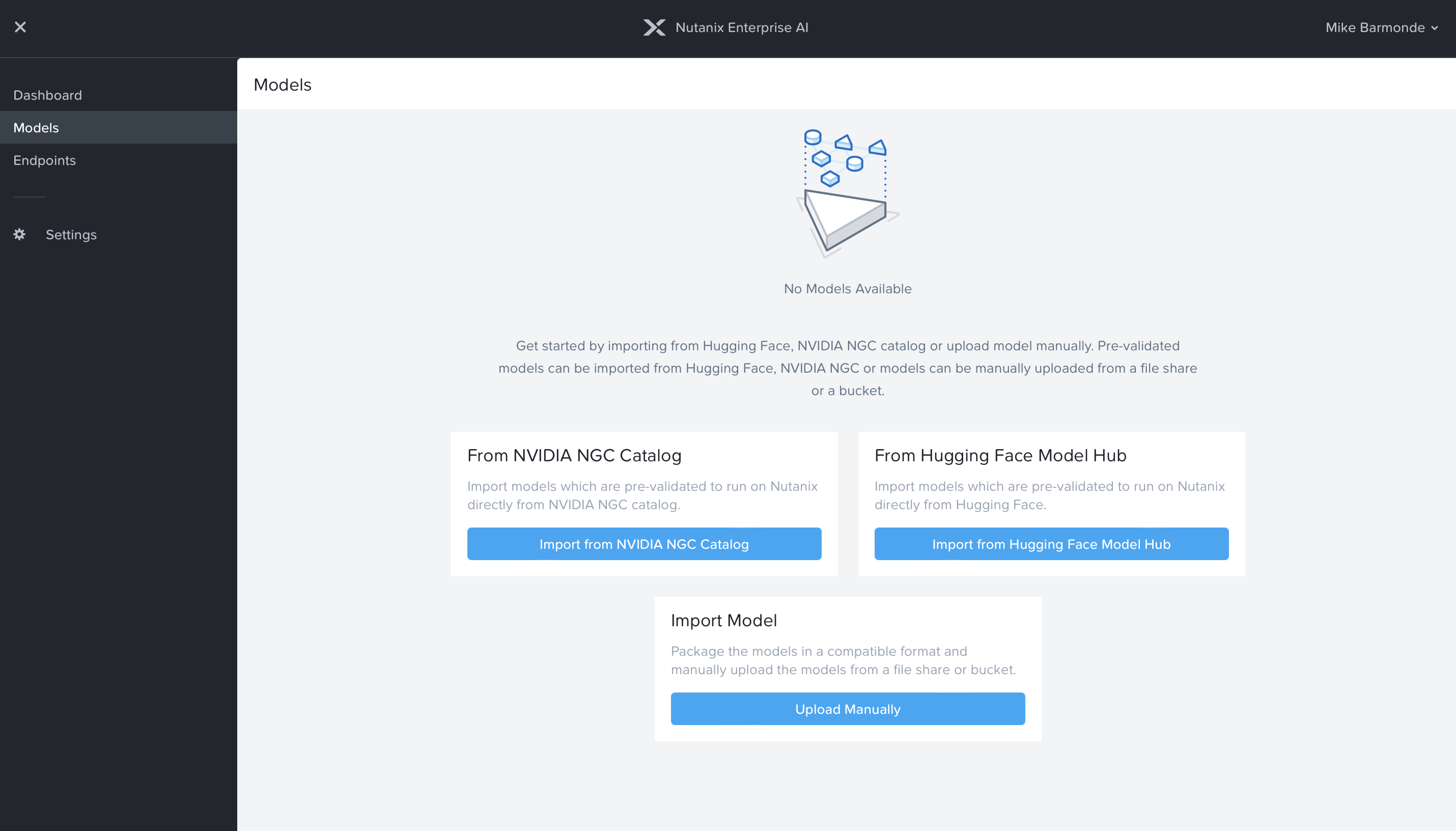

2. デプロイメントが完了したら、管理ログインを作成し、インポートする大規模言語モデル(LLM)を選択します。

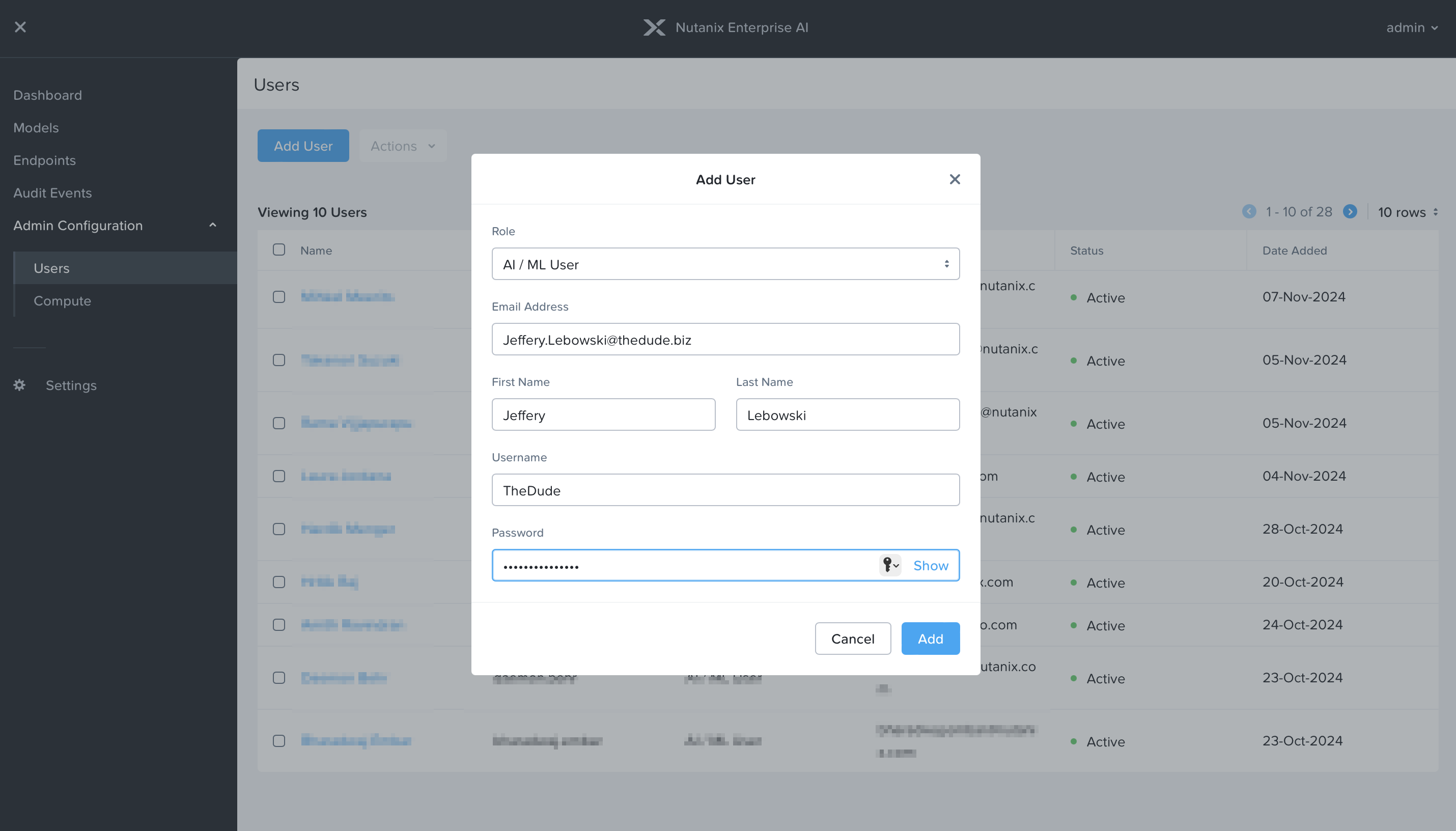

管理者以外のユーザーは、各ユーザーに関連付けられたロールベースのアクセス制御(RBAC)を使用して、モデルをデプロイし、API エンドポイントを作成できます。Nutanix Enterprise AI は、NVIDIA NIM(NVIDIA NGC カタログを使用)や Hugging Face と統合されています。また、独自のカスタムモデルをアップロードすることも可能です。モデルウィザードでは、モデルの保存プロセスを順を追って説明します。

注意:NVIDIA NIM と Hugging Face は、それぞれのモデルを使用するためにそれぞれのプラットフォームで作成された API キーを必要とし、その API キーとダウンロードしたモデルは Nutanix Enterprise AI に保存されます。

Nutanix Enterprise AI では、Hugging Face や NVIDIA NGC(NVIDIA NIM の一部)の Nutanix 検証済みモデルやインポートしたカスタムモデルなど、選択した AI モデル(LLM)をデプロイできます。

3. モデルが「アクティブ」の場合は、エンドポイントウィザードを使用して、モデル/ユーザーに対してセキュアなエンドポイント API を作成できます。

エンドポイントの命名から、ユーザーに関連付けられたモデルの選択まで、全てが効率化されます。API の作成は、マウスを数回クリックするだけで、このプロセスの一部となります。API キーが利用可能になったら、お気に入りのシークレットマネージャーを使用して保存/共有できます。

注意:API を作成する際、API キーは 1 つのウィンドウに表示され、その時点で文書化する必要があります。セキュリティ上の理由から再度提供することはできません。Nutanix Enterprise AI への個別のアクセスを可能にするために、個々のユーザーアカウントを作成することができ、各ユーザーは自分だけに紐付けられたモデルと API のみをデプロイ、管理できます。管理者は、必要に応じてユーザーのキーとモデルを容易に取り消したり非アクティブ化できます。

新規ユーザーの作成は、「管理者」か、自分のモデルとエンドポイントにのみアクセスできる「通常のユーザー」のどちらかを選択できます。管理者は、全てのユーザーの全てのモデルとエンドポイントにアクセスできます。

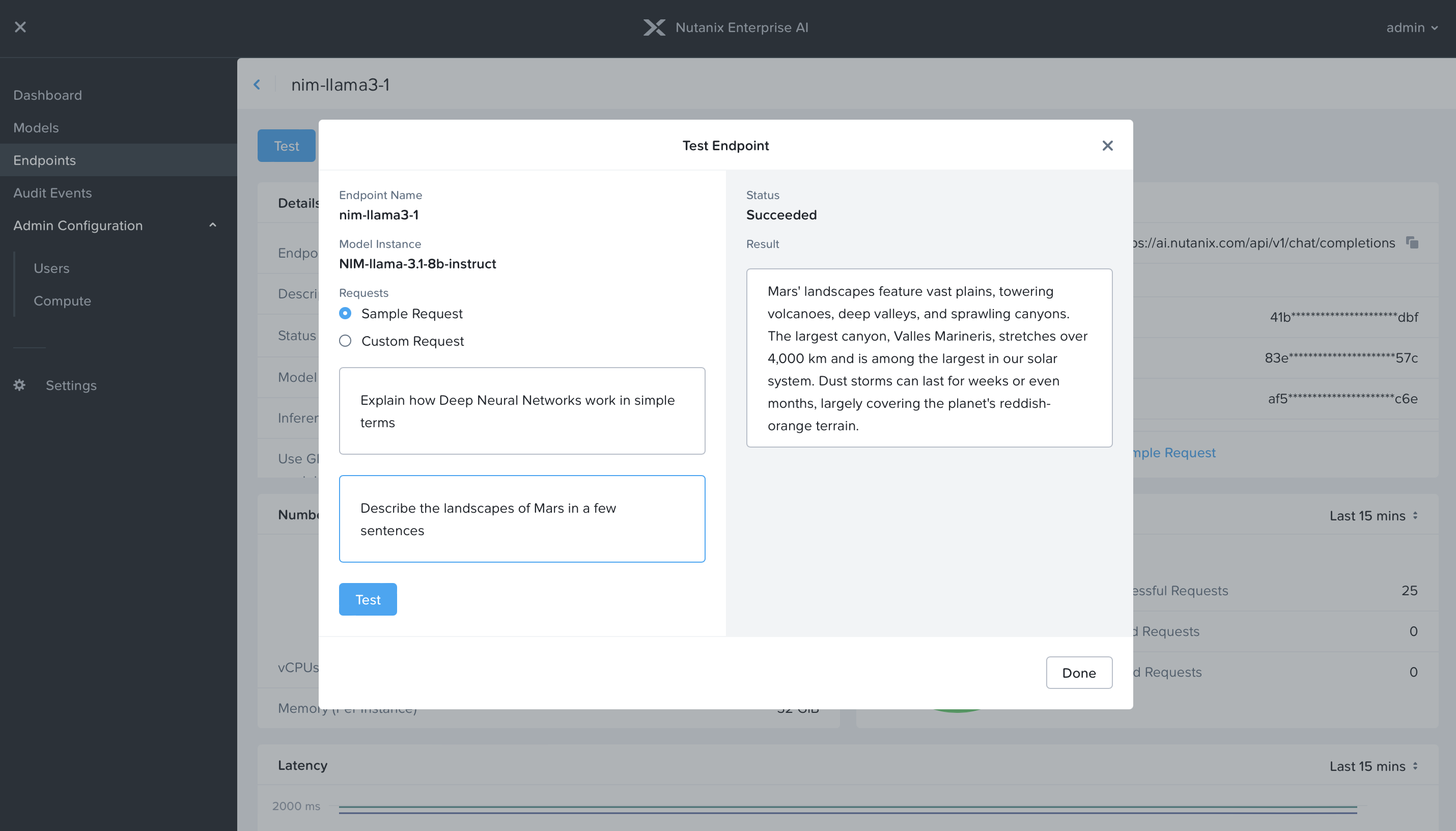

4. 最後に、新しい API とクエリを使用してデプロイされたモデルをテストし、検証された API をアプリケーションの所有者/開発者に渡します。

これは、一般的な生成 AI サービスを利用していると考えてみてください。質問をすると、AI モデルにクエリを実行し、生成された応答が返されます。この検証により、エンドポイント API が機能し、モデルが正しく動作することが保証されます。その後、API キーを開発者または生成 AI アプリケーションの所有者に送信して、AI モデル(LLM)へのアクセスを提供できます。

注意:モデルまたは API エンドポイントに変更が必要な場合(新しいモデルが要求された場合や API が取り消された場合)は、両方を更新または削除してから、アプリケーション用に再作成する(API キーを変更する)必要があります。このプロセスは数分しかかからず、メンテナンスウィンドウ内で完了できます。

NVIDIA NIM で示すように、Nutanix Enterprise AI 内でデプロイされたモデルとエンドポイントを簡単なサンプルクエリで迅速にテストできます。

これで完了です!

Nutanix Enterprise AI を使用すると、LLM とセキュア API のデプロイメントがポイントアンドクリック操作になり、新しいコマンドラインを学習したり、複雑な機能を調べたりするオーバーヘッドは必要ありません。エンタープライズ AI の導入が進むなか、Nutanix Enterprise AI を活用することで、IT リソースは迅速に AI リソースを提供できるようになります。

Nutanix Enterprise AI が生成 AI をシンプルに - 今すぐ始めましょう

エンタープライズ AI がエンタープライズテクノロジースタックに進出し続けるなか、IT リソースを AI リソースに移行してシンプルな AI Day 2 運用(LLM 運用)を提供し、生成 AI の次の大きな進展に適応する能力は、企業にとってもはや選択肢ではなく、必要不可欠な要素です。Nutanix GPT-in-a-Box 2.0 は、Nutanix Enterprise AI と組み合わせることで、効率的な運用、インフラ、サービスを提供する検証済みの強力なスタックとなり、企業がエンタープライズ AI をすぐに導入できるようサポートします。

次のステップ

- 簡単なクリックスルーデモをご覧ください。詳しくはこちらから。

- https://www.nutanix.com/jp/one-platform にアクセスして、Nutanix Enterprise AI をご自身のペースで試すことができます。

- 詳しくは、Nutanix GPT-in-a-Box 2.0 でのエンタープライズ AI 入門をご覧ください。

会社概要

Nutanix は、クラウドソフトウェアのグローバルリーダーであり、クラウド間でアプリやデータを運用するための単一プラットフォームを企業に提供しています。Nutanix の活用により、企業は複雑さの軽減と運用の簡素化を実現し、ビジネスの成果に集中することが可能になります。Nutanix は、HCI(ハイパーコンバージドインフラ)のパイオニアとしての実績をもとに、一貫したシンプルかつコスト効率の高いハイブリッド・マルチクラウド環境の構築を支援し、世界中の企業から高い信頼を獲得しています。詳細は、www.nutanix.com をご覧いただくか、ソーシャルメディアで @nutanix をフォローしてください。

©2024 Nutanix, Inc.All rights reserved.本文書に記載された、Nutanix、Nutanix のロゴ、および Nutanix のその他全ての製品およびサービス名は、米国およびその他の国において Nutanix, Inc. の登録商標または商標となります。Kubernetes® は、Linux Foundation の登録商標です。本書に記載されているその他のブランド名またはマークは、識別のみを目的としており、それぞれの所有者の商標である可能性があります。本ブログは情報提供のみを目的としており、Nutanix による保証またはその他の拘束力のあるコミットメントを構成するものではありません。このブログ投稿には、開発中の新製品の機能や技術、その機能や技術に関する将来性や発表計画など、当社の計画や予想に関する記述をはじめとして、将来の見通しに関する明示的および黙示的な記述が含まれる場合があります。既定の事実ではなく、当社の現時点における見通し、予測、信念に基づくものです。このような記述にはリスクと不確実性が伴い、その正確性は当社の管理できない事由を含む将来の事象に左右されます。また、実際の結果は、そのような記述によって予想または暗示されるものと大きく異なる場合や、逆である場合があります。本ブログに含まれる将来の見通しに関する記述は、本ブログの日付時点のものであり、法律に定められた場合を除き、当社は、その後の出来事または状況に合わせて、将来の見通しに関する記述を更新または変更する義務を負わないものとします。将来の製品または製品の機能情報は、製品の一般的な方向性を概説することを目的としており、Nutanix が何らかの機能を提供することに対するコミットメント、約束、または法的義務を示すものではありません。この情報は、購入の意思決定の際に使用されることを目的とするものではありません。外部サイトへのリンクまたは参照に関する当社の判断は、当該サイトにおけるいかなる内容の宣伝とも見なされるべきではありません。本コンテンツに含まれる一部の情報は、調査、発行物、アンケート、および第三者の情報源および当社が独自に行った社内の予測・研究におけるその他のデータに関連するか、これに基づいています。こうした第三者による調査、発行物、アンケ―ト、およびその他のデータは本紙の投稿時点で信頼性があるものの、明示的に記載されていない限り独自には検証されておらず、当社は第三者の情報源から取得した情報の適性、正確性、または完全性に関して一切の表明を行いません。